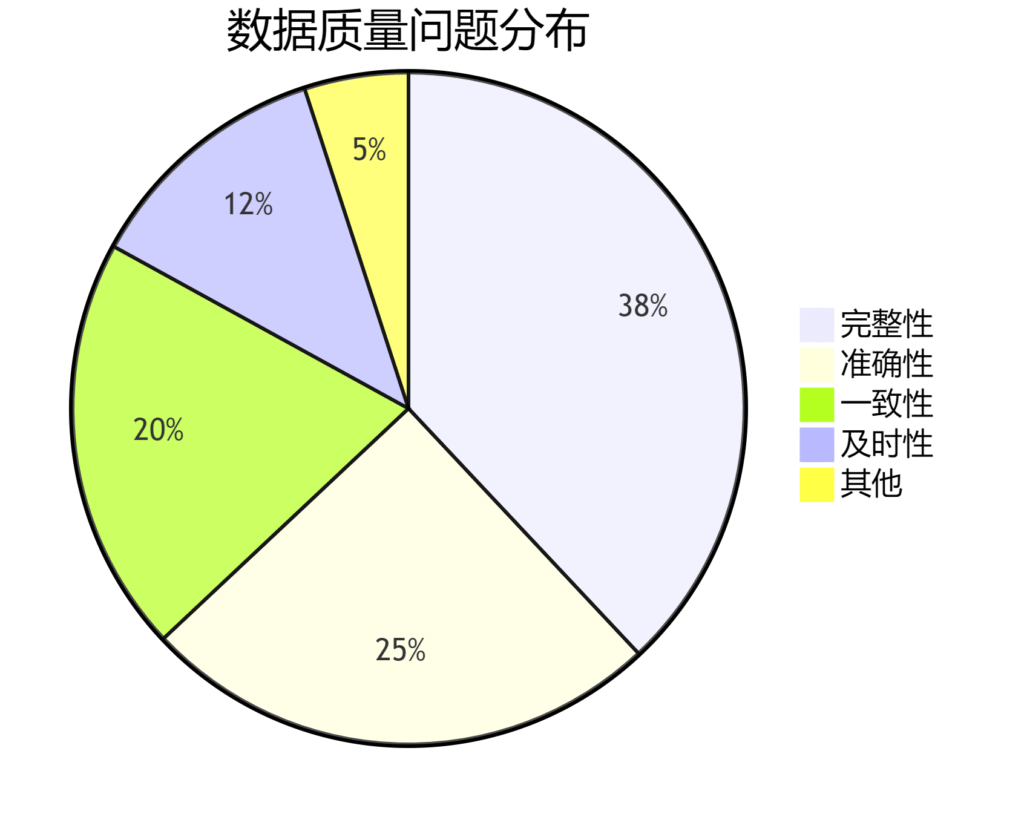

一、数据质量治理框架 1.1 质量维度定义 根据ISO 8000标准,结合工商数据特性制定6大质量维度:

维度 定义 典型问题示例 完整性 关键字段无缺失 统一社会信用代码字段为空 准确性 数据真实反映实际情况 注册资本单位错误(如将“万元”误为“元”) 一致性 多源数据间逻辑一致 同一企业在不同系统的成立日期不一致 及时性 数据更新频率符合业务需求 经营状态变更信息延迟超过3个工作日 唯一性 实体标识唯一无重复 同一信用代码对应多个企业名称 合规性 符合法律法规和行业规范 股东身份证号未脱敏存储

二、数据质量规则体系 2.1 基础质量规则库 (以下规则需写入元数据管理系统)

2.1.1 完整性规则 -- 示例:必填字段检查 SELECT credit_code FROM enterprise_info WHERE credit_code IS NULL OR enterprise_name IS NULL ; 2.1.2 准确性规则 # 示例:注册资本逻辑校验 def validate_capital ( registered_capital , paid_capital ): if paid_capital > registered_capital : raise ValueError ( " 实缴资本不得大于注册资本 " ) 2.1.3 一致性规则 -- 示例:跨系统数据比对 SELECT a.credit_code, a.reg_address, b.reg_address FROM local_db.enterprise a JOIN national_system.enterprise b ON a.credit_code = b.credit_code WHERE a.reg_address != b.reg_address; 2.2 高级质量规则

关联性校验 :时序性校验 :模式识别 :

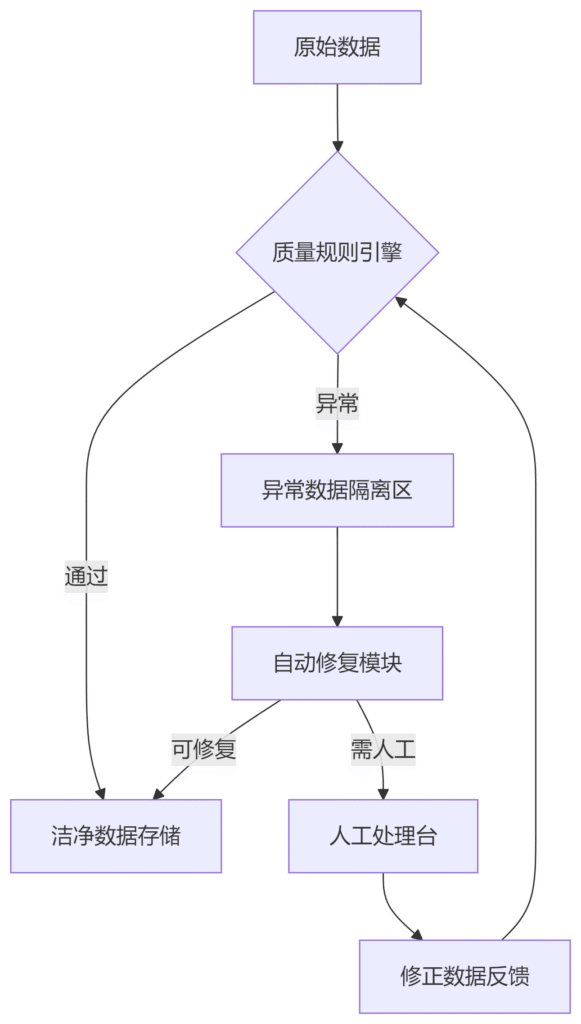

^[0-9A-HJ-NPQRTUWXY]{ 2 }\d{ 6 }[0-9A-HJ-NPQRTUWXY]{ 10 }$ 三、数据质量检测流程 3.1 质量检查架构 3.2 检测频率设置 数据类型 检测频率 执行方式 基础信息 每日全量扫描 凌晨2:00定时任务 变更记录 实时流式检测 Flink事件驱动 历史数据 月度抽样检查 随机抽取5%数据

四、数据清洗与修复 4.1 自动修复策略 问题类型 修复逻辑 示例 单位统一问题 自动转换单位并添加标记 "100万美元" → "650.00万元"(汇率6.5) 日期格式错误 按照YYYY-MM-DD标准化 "2023年5月1日" → "2023-05-01" 行政区划代码缺失 调用高德地图API补全 "北京市海淀区" → 补全"110108"

4.2 人工干预流程

问题分级 :

P0级:影响核心业务(如信用代码错误) → 4小时内处理

P1级:影响部分功能(如地址不完整) → 24小时内处理

P2级:轻微问题(如备注字段超长) → 72小时内处理

处理工单模板 :

## 数据修复工单 - ** 问题ID ** : DQ-20230815-001 - ** 异常数据 ** : credit_code=91440300MA5FXXXXXX, enterprise_name=空 - ** 修复建议 ** : 1. 从国家企业信用信息公示系统补全名称 2. 验证信用代码有效性 - ** 处理人 ** : 张三(数据治理组) 五、数据质量监控与报告 5.1 实时监控看板 5.2 质量报告模板 5.2.1 日报内容 # 工商数据质量日报(2023-08-15) ## 核心指标 - ** 数据总量 ** : 1,235,678 条 - ** 合格率 ** : 98.7%(↑0.2%) - ** 待处理问题 ** : 156 个 ## 重点问题TOP3 1. 注册资本单位缺失(45例) 2. 行政区划代码过期(32例) 3. 股东信息重复(28例) ## 改进建议 - 优化注册资本采集接口的单位自动识别功能 - 更新行政区划代码对照表至2023版 5.2.2 月报结构

质量趋势分析 :环比/同比合格率变化根本原因分析 :使用鱼骨图定位高频问题源头成本影响评估 :数据问题导致的业务损失估算改进路线图 :下阶段质量提升计划

六、工具链与平台建设 6.1 推荐工具矩阵 功能 开源方案 商业方案 关键能力 规则引擎 Apache Griffin Talend DQ 可视化规则配置、多数据源支持 数据剖析 Great Expectations Informatica DQ 数据分布分析、模式发现 质量可视化 Superset Tableau 自定义仪表盘、预警推送 异常跟踪 Jira + 自定义插件 Collibra Lineage 工单流转、修复过程追溯

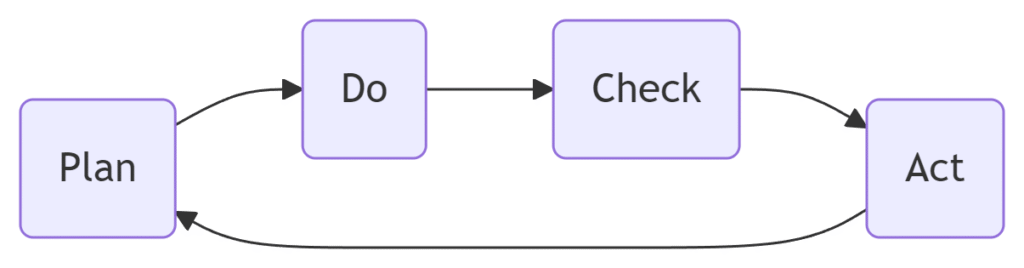

6.2 质量检查集成示例 # 使用Great Expectations进行质量检查 import great_expectations as ge # 加载数据 df = ge . read_csv ( " enterprise_data.csv " ) # 定义期望规则 expectation_suite = df . expect_column_values_to_not_be_null ( " credit_code " ) df . expect_column_values_to_match_regex ( " credit_code " , r " ^ [ 0-9A-HJ-NPQRTUWXY ] {2} \d {6} [ 0-9A-HJ-NPQRTUWXY ] {10} $ " ) # 生成报告 results = df . validate () ge . render . view . DefaultJinjaPageView (). render ( results ) 七、持续改进机制 7.1 PDCA循环实施

Plan :基于月度报告制定改进计划Do :在测试环境实施质量规则优化Check :通过AB测试验证改进效果Act :全量推广有效方案

7.2 成功度量指标 指标 计算公式 目标值 数据可用率 (合格数据量/总数据量)×100% ≥99.5% 平均修复时间(MTTR) 总修复耗时/处理问题数 ≤4小时 规则覆盖率 已实施规则数/已识别问题类型数×100% ≥95%

八、典型案例分析 案例:注册资本单位混乱治理

问题现象 :解决方案 :

开发单位智能识别模型(准确率98.7%)

建立货币汇率对照表(每日更新)

增加前端录入单位强制选择

实施效果 :

注册资本字段合格率从83%提升至99.9%

财务部门报表生成时间缩短40%

实施建议 :

分阶段推进 :优先治理高风险字段(如信用代码、注册资本)建立质量文化 :将数据质量指标纳入各部门绩效考核技术业务融合 :定期组织数据质量问题研讨会(业务+IT联合参与)

通过系统化的质量规则设计、智能化的检测手段、可视化的监控体系,可构建工商数据质量管理的完整闭环,为企业的数字化转型奠定坚实数据基础。